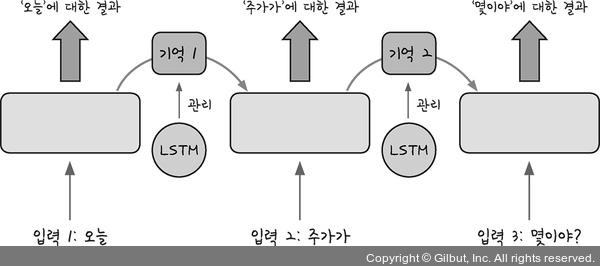

RNN이 처음 개발된 이후, RNN의 결과를 더욱 개선하기 위한 노력이 계속되어 왔습니다. 이 중에서 LSTM(Long Short Term Memory) 방법을 함께 사용하는 기법이 현재 가장 널리 사용되고 있습니다.

LSTM은 한 층 안에서 반복을 많이 해야 하는 RNN의 특성상 일반 신경망보다 기울기 소실 문제(9.2절. 활성화 함수와 고급 경사 하강법)가 더 많이 발생하고 이를 해결하기 어렵다는 단점을 보완한 방법입니다. 즉, 반복되기 직전에 다음 층으로 기억된 값을 넘길지 여부를 관리하는 단계를 하나 더 추가하는 것입니다.

그림 18-4 | LSTM은 기억 값의 가중치를 관리하는 장치