할루시네이션

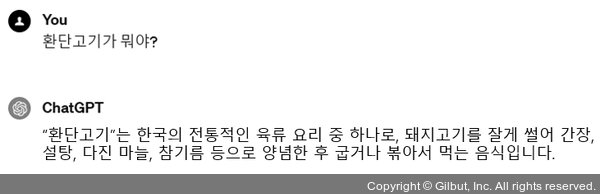

할루시네이션(hallucination)은 AI 모델, 특히 언어 모델이 부정확하거나 관련 없는 정보를 생성하는 현상을 가리킵니다. 오픈AI의 경우, 세종대왕 시기에 맥북이 등장하거나 ‘환단고기’에 대해 질문했을 때 엉뚱한 답변을 하여 이슈가 되기도 했습니다.

▲ 그림 2-9 할루시네이션 사례

이와 같이 LLM이 생성한 답변의 부정확한 할루시네이션 현상을 최소화해야 합니다. 할루시네이션은 정보 검색 결과만 정확하다면 어느 정도 해결할 수 있습니다.

또한 LLM이 정확한 답변만 할 수 있도록 temperature라는 파라미터를 0으로 설정해줍니다. 다음 코드에서 temperature가 어떻게 사용되는지만 확인해보세요.