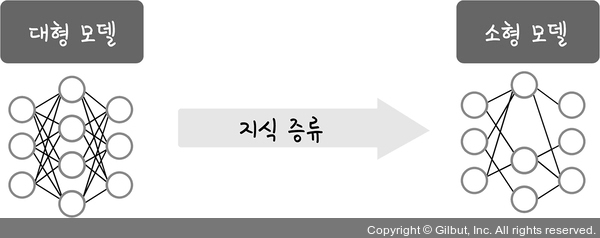

지식 증류

지식 증류(KD, Knowledge Distillation)란 매우 크고 복잡한 모델(수십억 개 이상의 파라미터를 가진 모델)이 학습한 고급 추론 능력과 지식을, 상대적으로 작은 모델(7억~14억 개의 파라미터를 가진 모델)로 전이하는 과정을 말합니다. 이 과정은 LLM이 학습한 패턴과 개념을 유지하면서 연산량과 메모리 사용을 줄여 경량화된 모델을 효율적으로 활용하는 데 중점을 둡니다.

DeepSeek는 이러한 지식 증류 기법을 활용하여, 대형 모델이 습득한 복잡한 논리 패턴, 자연어 처리 기술, 문제 해결 전략 등을 소형 모델로 압축하였습니다. 이를 통해 더 작은 모델이 제한된 자원에서도 강력한 성능을 발휘할 수 있도록 최적화되었습니다.

▲ 그림 3-10 지식 증류