앞에서 살펴본 시그모이드 함수와 하이퍼볼릭탄젠트 함수는 인공 신경망으로 학습할 때 여러 이유에서 학습이 효과적으로 되지 않는다는 단점이 있었습니다. 입력값이 아무리 커도 1보다 큰 수로는 내보내지 않기 때문입니다.

하지만 렐루 함수는 이를 해결한 새로운 함수입니다. 최근 인공 신경망을 학습시킬 때 활성화 함수로 주로 사용합니다. 이 함수 또한 입력값이 음수일 때 출력값이 0으로 같다는 단점이 있습니다. 이를 해결하기 위해 다음 그림과 같은 Leaky 렐루(Leaky ReLU) 함수 또한 새롭게 개발되어 사용되고 있습니다.

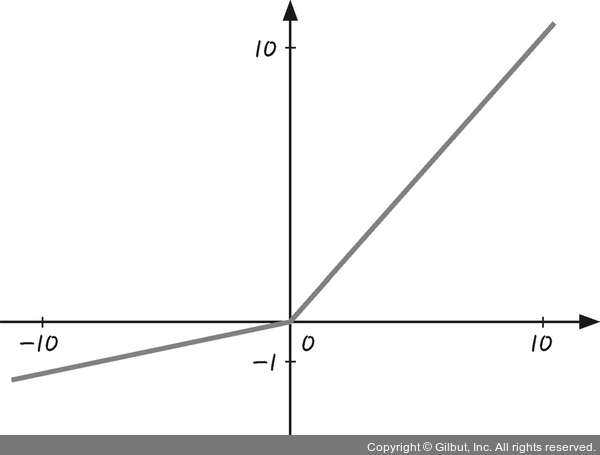

그림 5-13 Leaky 렐루 함수

그림 5-13과 같이 Leaky 렐루 함수는 음수일 때 0으로 출력되지 않고 양수일 때 기울기와는 다르게 기울기가 아주 완만한 것을 볼 수 있습니다. 즉, 전달받은 신호 세기의 합이 음수일 때 0인 값을 출력하지 않고, 미세하게나마 차이가 나는 음수 값을 전달한다는 특징이 있죠.