3.8.1 모델 아키텍처

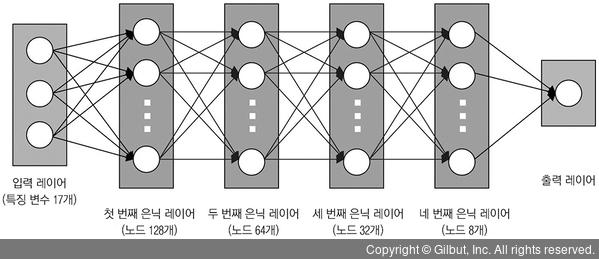

2장에서 사용한 신경망은 비교적 단순한 다중 레이어 퍼셉트론이었다. 이번 프로젝트는 더 많은 특징 변수를 사용하므로 더 깊은 모델로 복잡도를 늘려야 한다. 따라서 이번에는 은닉 레이어 네 개를 사용해 심층 전방향 신경망을 만든다. 첫 번째 은닉 레이어는 노드 128개로 구성하며, 레이어를 거칠수록 노드를 절반씩 줄인다. 우선 이 정도 크기로 신경망을 구성해야 훈련 시간이 오래 걸리지 않을 것이다. 이와 같이 우선 작게 만들고 필요에 따라 복잡도(즉, 크기)를 늘리는 게 좋다.

각 은닉 레이어의 활성화 함수는 비선형 함수인 ReLU를 사용한다. 또한, 회귀 모델이므로 출력 레이어의 노드는 한 개뿐이다(회귀는 다음 3.8.2절에서 더 자세히 설명한다). 출력 레이어에는 ReLU를 사용하지 않는다.

이번 프로젝트에서 만들 심층 전방향 신경망의 모델 아키텍처는 그림 3-16과 같다.

▲ 그림 3-16 심층 전방향 신경망의 모델 아키텍처