2.7.1.4 ReLU 활성화 함수

ReLU는 신경망 중간(즉, 출력 레이어 전)에 위치한 은닉 레이어에 주로 사용하는 활성화 함수다. 2011년 연구자들은 ReLU가 다른 활성화 함수보다 신경망을 더 잘 훈련시킨다는 것을 증명했다. 최근 심층 신경망은 대부분 ReLU를 기본 활성화 함수로 사용한다.

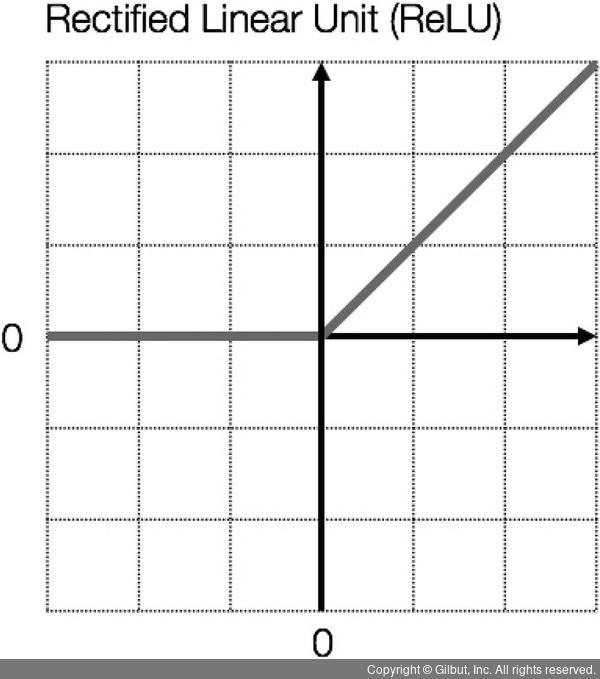

ReLU의 공식은 다음과 같다.

결국 ReLU 함수는 단순히 입력값 x가 양수일 때만 사용하고 음수를 무시해 모두 0으로 간주한다. 그림 2-14는 ReLU 함수를 그린 것이다.

▲ 그림 2-14 ReLU 함수