앞선 예제는 따라 하기 쉽도록 의도적으로 간단하게 만들었습니다. 이 예제가 역전파의 핵심을 알려 주지만, 실제 신경망 훈련에서 일어나는 역전파는 다음과 같은 측면에서 다릅니다.

• 단순한 훈련 샘플(이 예에서는 x = 2와 y = 5)을 제공하는 대신 일반적으로 여러 샘플로 구성된 배치를 제공합니다. 그레이디언트를 유도하는 데 사용되는 손실 값은 모든 개별 샘플의 손실에 대한 산술 평균입니다.

• 일반적으로 업데이트할 변수는 매우 많은 원소를 가집니다. 따라서 앞에서처럼 하나의 변수가 있는 단순한 도함수 대신에 종종 행렬 미분을 사용합니다.

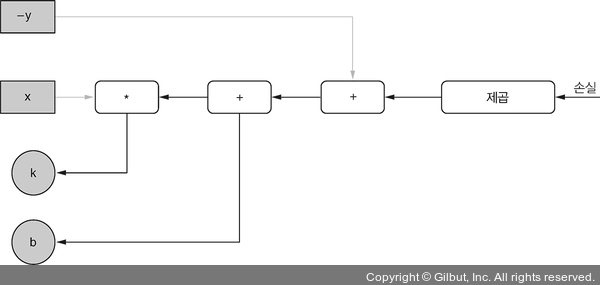

• 하나의 변수에 대한 그레이디언트를 계산하는 대신 일반적으로 여러 개의 변수가 관련됩니다. 그림 2-10은 최적화할 두 개의 변수를 가진 조금 더 복잡한 선형 모델인 y' = k * x + b를 보여 줍니다. 이 모델은 k 외에도 편향 b를 가지고 있습니다. 여기서는 두 개의 그레이디언트를 계산합니다. 하나는 k에 대한 그레이디언트이고, 다른 하나는 b에 대한 그레이디언트입니다. 두 역전파의 경로는 모두 손실에서 출발합니다. 이 경로는 일부 에지를 공유하며 트리와 같은 구조를 형성합니다.

▲ 그림 2-10 손실에서 업데이트할 두 개의 가중치(k와 b)로 역전파되는 것을 보여 주는 그림