그다음, 밀집 층의 최종 출력은 다음과 같이 시그모이드(S) 함수를 50개의 유닛에 대해 개별적으로 호출하여 얻어집니다.

[[S(1.0)], [S(0.5)], ..., [S(0.0)]] = [[0.731], [0.622], ..., [0.0]]

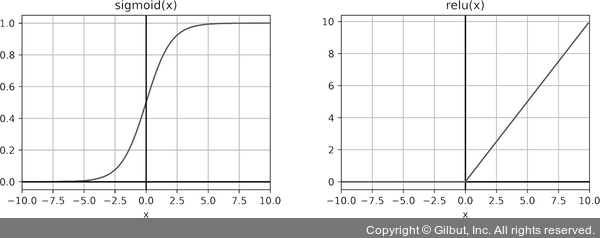

왜 이 함수를 비선형이라고 부르는 걸까요? 간단히 말하면 이 활성화 함수의 그래프가 직선이 아니기 때문입니다. 예를 들어 시그모이드(그림 3-2의 왼쪽)는 곡선이고, 렐루(rectified linear unit, relu)(그림 3-2의 오른쪽)는 두 직선을 연결한 것입니다. 시그모이드와 렐루가 비선형이지만 모든 점에서 연속적이고 미분 가능하다는 것이 하나의 특징입니다.5 따라서 이런 함수는 역전파를 수행할 수 있습니다.6 이런 성질이 없다면 이 활성화 함수가 있는 층으로 구성된 모델을 훈련할 수 없습니다.

▲ 그림 3-2 심층 신경망에서 자주 사용하는 두 개의 비선형 활성화 함수. 왼쪽: 시그모이드 함수 S(x) = 1 / (1 + e-x). 오른쪽: 렐루 함수 relu(x) = {0:x < 0, x:x >= 0}

시그모이드 함수 외에도 딥러닝에서 자주 사용되는 미분 가능한 비선형 함수들이 몇 가지 있습니다. 여기에는 렐루 함수, 하이퍼볼릭 탄젠트(hyperbolic tangent, tanh) 함수가 포함됩니다. 나중에 예제에서 이 함수들이 등장할 때 자세히 설명하겠습니다.