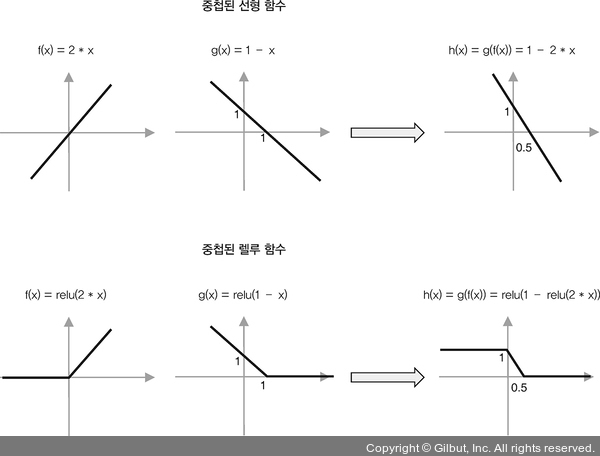

▲ 그림 3-3 중첩된 선형 함수(위)와 비선형 함수(아래). 선형 함수를 중첩하면 기울기와 절편이 다르지만 언제나 선형 함수가 된다. (이 예에서는 렐루 같은) 비선형 함수를 중첩하면 새로운 형태의 비선형 함수를 만든다. 여기에서는 ‘내려가는 계단 함수’가 된다. 이 예는 비선형 활성화 함수를 중첩하는 것이 표현 능력(즉, 용량)을 증가시키는 이유를 보여 준다.

머신 러닝 모델이 학습할 수 있는 입력-출력 관계의 범위를 종종 모델의 용량(capacity)이라고 부릅니다. 앞서 비선형성에 대해 논의했을 때 은닉층과 비선형 활성화 함수를 가진 신경망이 선형 회귀 모델에 비해 더 용량이 크다는 것을 알 수 있습니다. 또한, 두 개의 층을 가진 네트워크가 선형 회귀 모델에 비해 훨씬 높은 테스트 세트 정확도를 달성한 이유를 설명해 줍니다.