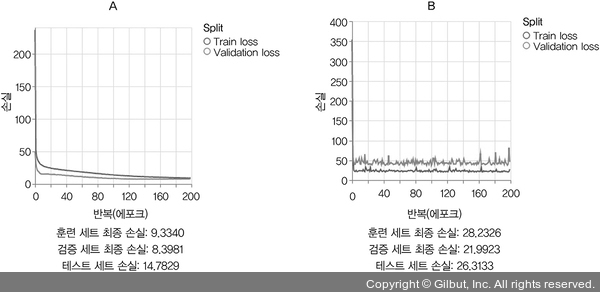

이 변화가 모델 학습에 어떤 영향을 미칠까요? 화면에서 신경망 회귀 모델 훈련 (은닉층 한 개) 버튼을 다시 클릭하면 볼 수 있듯이 테스트 세트에 대한 MSE는 약 25까지 올라갑니다.9 시그모이드 활성화 함수가 있을 때는 14~15 범위였습니다. 다른 말로 하면, 시그모이드 활성화 함수가 없는 두 개의 층을 가진 모델은 하나의 층을 가진 선형 회귀 모델과 성능이 비슷합니다!

이는 선형 함수를 중첩했을 때 예상했던 것을 확인시켜 줍니다. 첫 번째 층의 비선형 활성화 함수를 제거했으므로 두 개의 선형 함수를 중첩한 모델이 됩니다. 앞서 설명했듯이 이는 모델의 용량이 증가되지 않는 또 다른 선형 함수가 됩니다. 따라서 선형 모델과 거의 동일한 성능을 달성하는 것이 놀랍지 않습니다. 다층 신경망을 구축할 때 항상 필요한 것은 은닉층에 비선형 활성화 함수를 추가하는 것입니다. 이를 빼먹으면 계산 자원과 시간을 낭비하는 결과를 초래하고 수치적으로 불안정성이 높아집니다(그림 3-4의 B에 있는 구불구불한 손실 곡선을 참고하세요). 나중에 이것이 밀집 층뿐만 아니라 합성곱 층 같은 다른 종류의 층에도 적용된다는 사실을 알게 될 것입니다.

▲ 그림 3-4 시그모이드 활성화 함수가 있는 모델(A)과 없는 모델(B)의 훈련 결과 비교. 시그모이드 활성화 함수를 없애면 훈련, 검증, 테스트 세트에서 (이전의 순수한 선형 모델과 비슷한 수준으로) 최종 손실 값이 더 높아지고 손실 곡선이 구불구불해진다. 두 그래프의 y축의 범위가 다른 점을 눈여겨보자.