신경망 학습은 가중치 w의 조절 작업이다. 입력 값 X와 원하는 출력 값 Y가 있을 때 입력 값을 입력층에 준 다음, 모델의 출력 값이 원하는 출력 값과 같은지를 확인한다. 값이 같지 않다면 가중치 w를 적절히 조절한다.

모델의 출력 값이 원하는 출력 값과 얼마나 같은지를 비교하는 기준에는

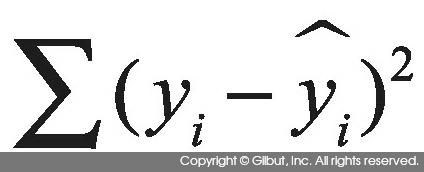

에러의 제곱 합SSE, Sum of Squared

Error과 정보 이론의 엔트로피가 있다. 출력층 노드 i의 출력 값이  , 원하는 출력 값이

, 원하는 출력 값이  라 할 때 SSE는 식 9-5와 같다.

라 할 때 SSE는 식 9-5와 같다.

식 10-5에서 차이가 발견되면 (즉, 식 10-5가 0이 아니면) 차이가 발생한 출력 노드로부터 해당 출력 노드에 연결된 은닉 노드로, 은닉 노드에서 입력 노드로 거슬러 올라가면서 가중치를 조절하여 식 10-5가 0에 가까워지도록 한다. 이를 수회 반복하다 보면 적절한 가중치가 발견된다. 이 학습 방법을 역전파 알고리즘Back Propagation Algorithm이라 한다. 역전파 알고리즘은 홉필드Hopfield가 개발한 것으로, 이 알고리즘의 개발 덕분에 신경망 모델이 널리 사용되게 되었다.

신경망 모델의 학습 과정에서 주어진 데이터에 딱 맞게 가중치를 조절하다 보면 과적합이 발생할 수 있다. 과적합을 피하는 한 가지 방법은 역전파 알고리즘에 따라 가중치를 교정할 때마다 0과 1 사이의 값을 가지는 ε을 가중치에 곱해주는 것이다. 이를 가중치 감소weight decay라 한다.

w = w × (1-ε) (식 10-6)

신경망의 출력으로 확률을 원할 경우 최솟값이 0, 최댓값이 1이 되도록 해주는 소프트맥스 함수를 사용한다. 식 10-7은 출력 노드 k의 넷 활성화가 netk일 때 노드 k의 소프트맥스를 구하는 식이다.

이상으로 신경망 모델에 대해 살펴봤다. 더 자세한 내용은 이 절을 설명하면서 사용한 참고자료 [11], [12]를 보기 바란다.