아직 무슨 차이인지 잘 모르겠다면 딥러닝 학습에 많이 사용하는 GPU가 연결된 컴퓨터를 예로 들어 비교해보겠습니다. 일반적으로 딥러닝 연산을 위해서는 서버 컴퓨터에 GPU가 연결되어 있어야 합니다. 이 GPU는 메인보드의 PCI 슬롯을 통해 컴퓨터의 메인 메모리와 GPU의 메모리 간 데이터를 주고받으면서 모델의 가중치를 업데이트하며 딥러닝 학습을 하게 됩니다. 여기서 해당 GPU는 컴퓨터에 ‘물리적’으로 연결된 상태인 것입니다.

그렇다면 물리적으로 연결된 상태가 아니라 GPU가 네트워크 클라우드 위에 있다고 생각해봅시다. 그럼 GPU는 임의의 IP를 가지게 되고 컴퓨터로부터 머신러닝 모델 구조 코드와 데이터셋을 네트워크를 통해 주고받으면서 딥러닝 학습을 하게 될 것입니다.

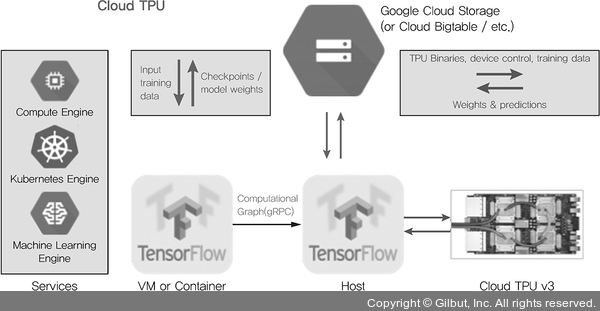

▲ 그림 7-13 Cloud TPU 학습 구조도8