Note ≡ 평균 제곱 오차 미분

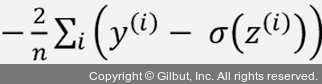

미분에 익숙하다면 j번째 가중치에 대한 MSE 손실 함수의 편도 함수를 다음과 같이 얻을 수 있습니다.

편도 함수  을 구하는데 같은 방식을 사용할 수 있습니다. 이 경우

을 구하는데 같은 방식을 사용할 수 있습니다. 이 경우  가 -1이므로 마지막 단계에서

가 -1이므로 마지막 단계에서  가 됩니다.

가 됩니다.

아달린 학습 규칙이 퍼셉트론 규칙과 동일하게 보이지만 z(i) = wTx(i)+b인  는 정수 클래스 레이블이 아니고 실수입니다. 또한, 훈련 데이터셋에 있는 모든 샘플을 기반으로 가중치 업데이트를 계산합니다(각 샘플마다 가중치를 업데이트하지는 않습니다). 이 방식을 배치 경사 하강법(batch gradient descent)이라고도 합니다. 이 장과 책에서 이에 관련된 개념을 이야기할 때 혼동을 피하고 명확하게 하기 위해 이 방식을 완전 배치 경사 하강법(full batch gradient descent)이라고 하겠습니다.

는 정수 클래스 레이블이 아니고 실수입니다. 또한, 훈련 데이터셋에 있는 모든 샘플을 기반으로 가중치 업데이트를 계산합니다(각 샘플마다 가중치를 업데이트하지는 않습니다). 이 방식을 배치 경사 하강법(batch gradient descent)이라고도 합니다. 이 장과 책에서 이에 관련된 개념을 이야기할 때 혼동을 피하고 명확하게 하기 위해 이 방식을 완전 배치 경사 하강법(full batch gradient descent)이라고 하겠습니다.