2.3.4 대규모 머신 러닝과 확률적 경사 하강법

이전 절에서 전체 훈련 데이터셋에서 계산한 그레이디언트의 반대 방향으로 한 걸음씩 진행하여 손실 함수를 최소화하는 방법을 배웠습니다. 이 방식을 이따금 완전 배치 경사 하강법이라고도 부릅니다. 수백만 개의 데이터 포인트가 있는 매우 큰 데이터셋을 생각해 보죠. 많은 머신 러닝 애플리케이션에서 이런 데이터셋은 드문 일이 아닙니다. 이때 완전 배치 경사 하강법을 실행하면 계산 비용이 매우 많이 듭니다. 전역 최솟값으로 나아가는 단계마다 매번 전체 훈련 데이터셋을 다시 평가해야 하기 때문입니다.

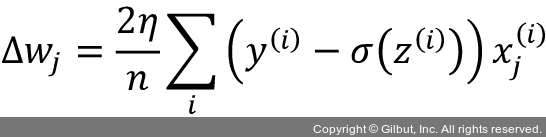

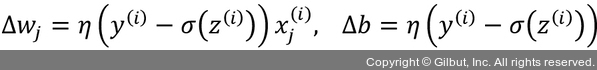

확률적 경사 하강법(stochastic gradient descent)은 배치 경사 하강법의 다른 대안으로 인기가 높습니다. 이따금 반복 또는 온라인 경사 하강법이라고도 부릅니다. 다음 첫 번째 수식처럼 모든 샘플 x(i)에 대하여 누적된 오차의 합을 기반으로 가중치를 업데이트하는 대신 두 번째 수식처럼 각 훈련 샘플에 대해 점진적으로 파라미터를 업데이트합니다.