5.3.1 비선형 차원 축소를 고려하는 이유는 무엇인가요?

많은 머신 러닝 알고리즘은 입력 데이터가 선형적으로 구분 가능하다는 가정을 합니다. 퍼셉트론은 수렴하기 위해 훈련 데이터가 선형적으로 완벽하게 분리 가능해야 한다고 배웠습니다. 지금까지 다루었던 다른 알고리즘들은 선형적으로 완벽하게 분리되지 못한 이유를 잡음 때문이라고 가정합니다. 예를 들어 아달린, 로지스틱 회귀, (기본) SVM입니다.

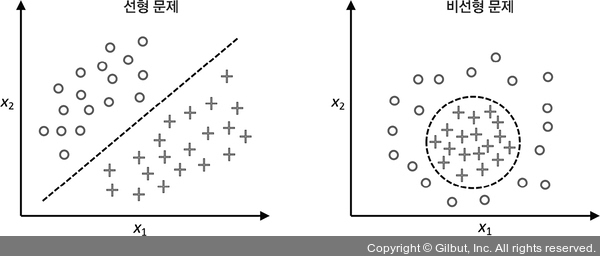

실전 애플리케이션에서 더 자주 맞닥뜨리게 될 비선형 문제를 다루어야 한다면 PCA와 LDA 같은 차원 축소를 위한 선형 변환 기법은 최선의 선택이 아닙니다.

▲ 그림 5-13 선형 문제와 비선형 문제의 차이점

사이킷런 라이브러리에는 비선형 차원 축소를 위한 고급 기법이 구현되어 있지만 이 책의 범위를 벗어납니다. 관심 있는 독자는 http://scikit-learn.org/stable/modules/manifold.html에서 예제와 함께 현재 사이킷런 구현에 대한 설명을 볼 수 있습니다.