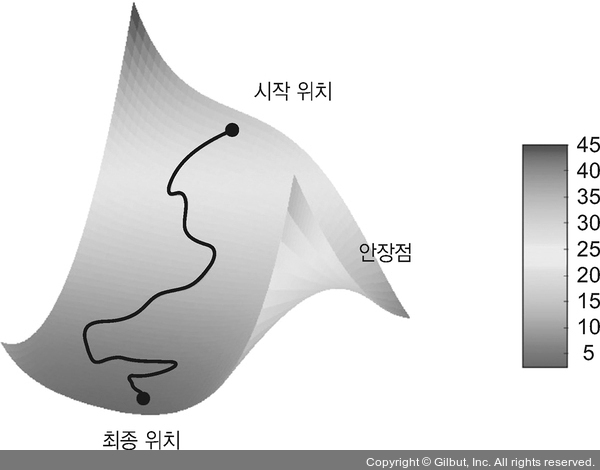

▲ 그림 2-19 경사 하강법이 2D 손실 함수(2개의 학습 파라미터)의 값을 낮춘다

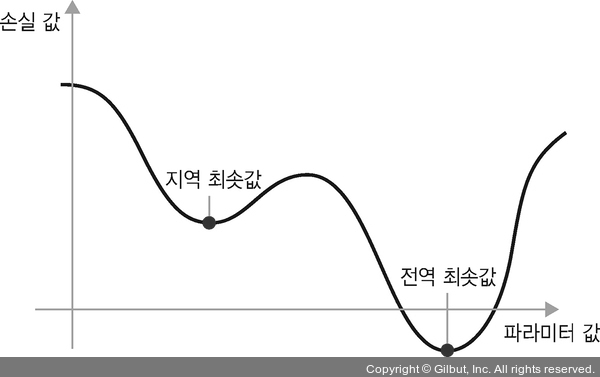

또한, 업데이트할 다음 가중치를 계산할 때 현재 그레이디언트 값만 보지 않고 이전에 업데이트된 가중치를 여러 가지 다른 방식으로 고려하는 SGD 변종이 많이 있습니다. 예를 들어 모멘텀을 사용한 SGD, Adagrad, RMSProp 등입니다. 이런 변종들을 모두 최적화 방법(optimization method) 또는 옵티마이저라고 부릅니다. 특히 여러 변종에서 사용하는 모멘텀(momentum) 개념은 아주 중요합니다. 모멘텀은 SGD에 있는 2개의 문제점인 수렴 속도와 지역 최솟값을 해결합니다. 그림 2-20은 모델의 파라미터 하나에 대한 손실 값의 곡선을 보여 줍니다.

▲ 그림 2-20 지역 최솟값(local minimum)과 전역 최솟값(global minimum)