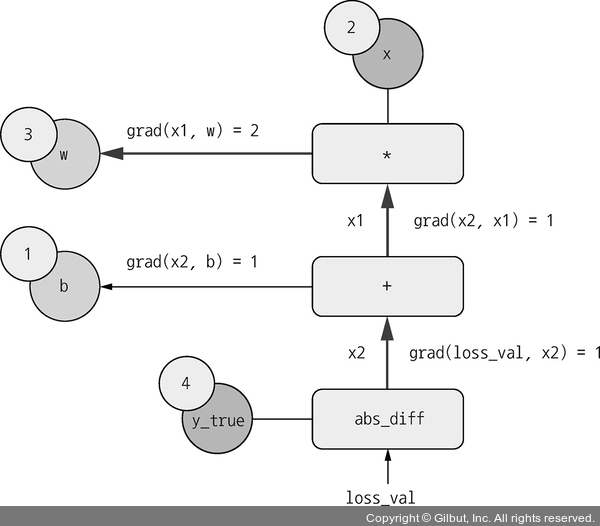

다음과 같은 값을 얻을 수 있습니다.

• grad(loss_val, x2) = 1입니다. x2가 epsilon만큼 변할 때 loss_val = abs(4 - x2)가 같은 양만큼 변하기 때문입니다.

• grad(x2, x1) = 1입니다. x1이 epsilon만큼 변할 때 x2 = x1 + b = x1 + 1이 같은 양만큼 변하기 때문입니다.

• grad(x2, b) = 1입니다. b가 epsilon만큼 변할 때 x2 = x1 + b = 6 + b가 같은 양만큼 변하기 때문입니다.

• grad(x1, w) = 2입니다. w가 epsilon만큼 변할 때 x1 = x * w = 2 * w는 2 * epsilon만큼 변하기 때문입니다.

연쇄 법칙이 역방향 그래프에 대해 알려 주는 것은 노드가 연결된 경로를 따라 각 에지의 도함수를 곱하면 어떤 노드에 대한 다른 노드의 도함수를 얻을 수 있다는 것입니다. 예를 들어 grad(loss_val, w) = grad(loss_val, x2) * grad(x2, x1) * grad(x1, w)입니다(그림 2-25).

▲ 그림 2-25 역방향 그래프에서 loss_val부터 w까지의 경로