이를 해결하고자 제프리 힌튼 교수는 렐루(ReLU)라는 새로운 활성화 함수를 제안했습니다.

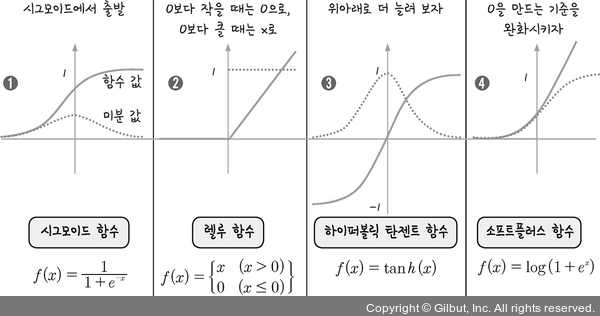

그림 9-6 | 여러 활성화 함수의 도입

그림 9-6 ➋에 있는 렐루는 x가 0보다 작을 때 모든 값을 0으로 처리하고, 0보다 큰 값은 x를 그대로 사용하는 방법입니다. 파란색 점선이 미분을 한 결과인데, 그림에서 보이듯 x가 0보다 크기만 하면 미분 값은 1이 됩니다. 따라서 활성화 함수로 렐루를 쓰면 여러 번 오차 역전파가 진행되어도 맨 처음 층까지 값이 남아 있게 됩니다. 학습은 결국 오차를 최소화하는 가중치를 찾는 과정이라고 했습니다. 출력층에서 알아낸 오차가 역전파를 통해 입력층까지 거슬러 올라가면서 잘못된 가중치들을 수정할 수 있게 되자, 더 깊은 층을 쌓아 올리는 것이 가능해졌습니다.

활성화 함수는 그 이후로도 여러 데이터 과학자에 의해 연구되어 ➌ 하이퍼볼릭 탄젠트(hyperbolic tangent) 함수나 ➍ 소프트플러스(softplus) 함수 등 좀 더 나은 활성화 함수를 만들기 위한 노력이 이어지고 있습니다.