3 단어 임베딩

원-핫 인코딩과 함께 공부해야 할 것이 한 가지 더 있습니다. 원-핫 인코딩을 그대로 사용하면 벡터의 길이가 너무 길어진다는 단점이 있습니다. 예를 들어 1만 개의 단어 토큰으로 이루어진 말뭉치를 다룬다고 할 때, 이 데이터를 원-핫 인코딩으로 벡터화하면 9,999개의 0과 하나의 1로 이루어진 단어 벡터를 1만 개나 만들어야 합니다. 이러한 공간적 낭비를 해결하기 위해 등장한 것이 단어 임베딩(word embedding)이라는 방법입니다.

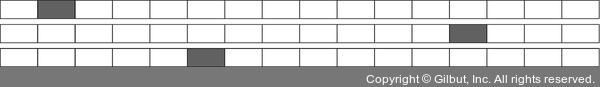

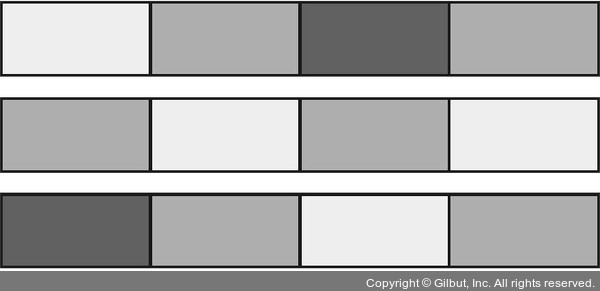

단어 임베딩은 주어진 배열을 정해진 길이로 압축시킵니다. 그림 17-1은 원-핫 인코딩을 사용해 만든 16차원 벡터가 단어 임베딩을 통해 4차원 벡터로 바뀐 예를 보기 쉽게 비교한 것입니다.

▲ 원-핫 인코딩

▲ 단어 임베딩

그림 17-1 | 원-핫 인코딩과 단어 임베딩