활성화 함수

다음으로 함수들에 대해 알아보겠습니다. 먼저 활성화 함수는 전달 함수에서 전달받은 값을 출력할 때 일정 기준에 따라 출력 값을 변화시키는 비선형 함수1입니다. 활성화 함수로는 시그모이드(sigmoid), 하이퍼볼릭 탄젠트(hyperbolic tangent), 렐루(ReLU) 함수 등이 있습니다. 시그모이드 함수부터 하나씩 살펴보겠습니다.

시그모이드 함수

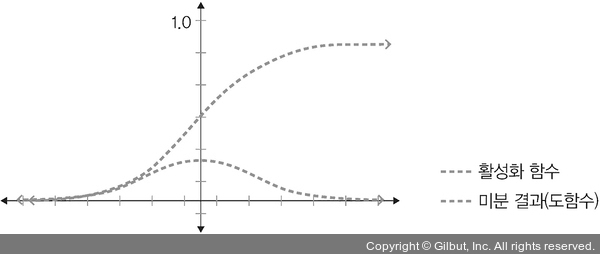

시그모이드 함수는 선형 함수의 결과를 0~1 사이에서 비선형 형태로 변형해 줍니다. 주로 로지스틱 회귀와 같은 분류 문제를 확률적으로 표현하는 데 사용됩니다. 과거에는 인기가 많았으나, 딥러닝 모델의 깊이가 깊어지면 기울기가 사라지는 ‘기울기 소멸 문제(vanishing gradient problem)2’가 발생하여 딥러닝 모델에서는 잘 사용하지 않습니다.

시그모이드는 다음 수식을 사용합니다.

▲ 그림 4-8 시그모이드 활성화 함수와 미분 결과