10.2.2 버트(BERT)

2018년 11월, 구글이 공개한 인공지능(AI) 언어 모델 BERT(Bidirectional Encoder Representations from Transformers)(이하 버트)는 기존의 단방향 자연어 처리 모델들의 단점을 보완한 양방향 자연어 처리 모델입니다. 검색 문장의 단어를 입력된 순서대로 하나씩 처리하는 것이 아니라, 트랜스포머를 이용하여 구현되었으며 방대한 양의 텍스트 데이터로 사전 훈련된 언어 모델입니다.

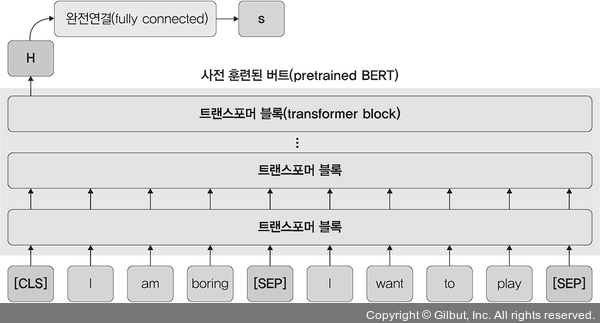

▲ 그림 10-23 버트 모델

버트의 기본 구조는 그림 10-23과 같이 트랜스포머(transformer)라는 인코더를 쌓아 올린 구조로, 주로 문장 예측(Next Sentence Prediction, NSP)을 할 때 사용합니다. 튜닝4을 통해 최고의 성능을 낸 기존 사례들을 참고해서 사전 학습된 버트 위에 분류를 위한 신경망을 한층 추가하는 방식을 사용합니다. 즉, 버트는 트랜스포머와 사전 학습을 사용하여 성능을 향상시킨 모델입니다.