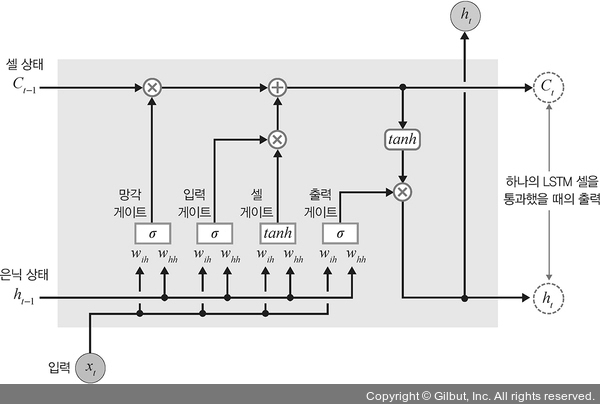

①, ①′ self.x2h = nn.Linear(input_size, 4 * hidden_size, bias=bias)와 self.h2h = nn.Linear(hidden_size, 4 * hidden_size, bias=bias)에서 4 * hidden_size가 사용되고 있는 이유에 대해 생각해 볼 필요가 있습니다. 왜 은닉층의 뉴런/유닛에 4를 곱할까요? 그 답을 알기 위해서는 다음 그림을 먼저 이해해야 합니다.

▲ 7-23 LSTM 게이트