배치 정규화

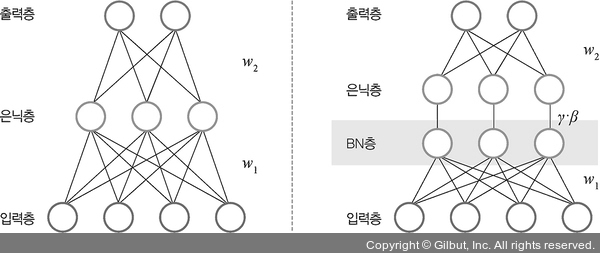

배치 정규화(batch normalization)는 2015년 “Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift” 논문에 설명되어 있는 기법으로, 데이터 분포가 안정되어 학습 속도를 높일 수 있습니다.

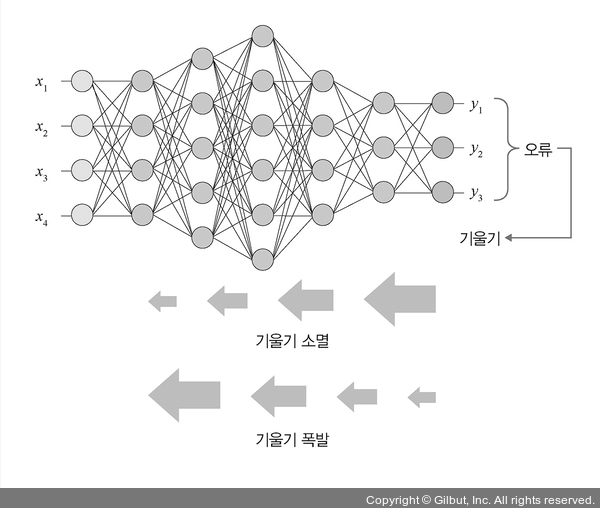

배치 정규화는 기울기 소멸(gradient vanishing)이나 기울기 폭발(gradient exploding) 같은 문제를 해결하기 위한 방법입니다. 일반적으로 기울기 소멸이나 폭발 문제를 해결하기 위해 손실 함수로 렐루(ReLU)를 사용하거나 초깃값 튜닝, 학습률(learning rate) 등을 조정합니다.

Note ≡ | 기울기 소멸과 기울기 폭발

• 기울기 소멸: 오차 정보를 역전파시키는 과정에서 기울기가 급격히 0에 가까워져 학습이 되지 않는 현상입니다.

• 기울기 폭발: 학습 과정에서 기울기가 급격히 커지는 현상입니다.

▲ 그림 8-34 기울기 소멸과 기울기 폭발

▲ 그림 8-35 배치 정규화