정확하게 번역되었는지 확인하기 위해 구글과 같은 번역 사이트를 이용해 보세요. 정확하지는 않지만 비슷하게 번역된 듯합니다.

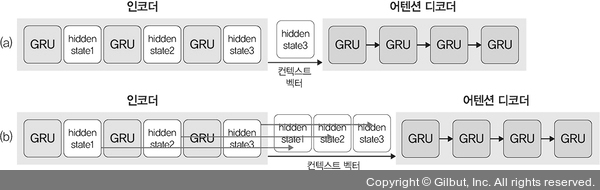

seq2seq는 인코더와 디코더 네트워크를 사용합니다. 하지만 일반적인 seq2seq 모델은 입력 문장이 긴 시퀀스일 경우 정확한 처리가 어렵습니다. 그림 10-20의 (a)와 같이 인코더에서 사용하는 RNN(LSTM, GRU)의 마지막 은닉 상태만 디코더로 전달되기 때문입니다. 즉, 다음과 같은 이유로 어텐션 메커니즘(attention mechanism)이 등장했습니다.

1. 하나의 고정된 크기의 벡터에 모든 정보를 담다 보니 정보의 손실 발생

2. RNN에서 발생할 수 있는 기울기 소멸(vanishing gradient) 문제 발생

어텐션 메커니즘은 그림 10-20의 (b)와 같이 디코딩 프로세스 동안 입력 시퀀스의 모든 숨겨진 상태를 유지하고 활용하기 때문에 정보의 손실과 기울기 소멸 문제가 발생하지 않습니다. 즉, 그림 10-20의 (b)와 같이 컨텍스트 벡터는 인코더의 전체 은닉 상태들과 디코더의 이전 은닉 상태를 바탕으로 만들어집니다.

▲ 그림 10-20 어텐션 디코딩