Note ≡ 로지스틱 회귀를 위한 경사 하강법 학습 알고리즘

앞의 LogisticRegressionGD 코드와 2장의 AdalineGD 코드를 비교해 보면 (2를 곱한 것만 빼고) 가중치와 절편 업데이트 규칙이 바뀌지 않았습니다. 미분을 사용하면 경사 하강법을 통한 파라미터 업데이트가 로지스틱 회귀와 아달린에서 비슷하다는 것을 알 수 있습니다. 다음에 나오는 경사 하강법 학습 규칙의 유도는 로지스틱 회귀를 위한 경사 하강법 이면에 있는 수학적 개념에 관심 있는 독자를 위한 것입니다. 이 장의 나머지 내용을 따라가기 위해 필수적이지 않습니다.

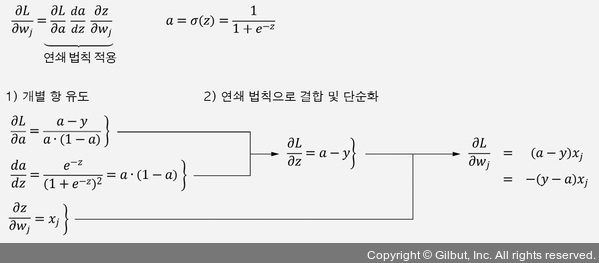

그림 3-6은 j번째 가중치에 대해 로그 가능도 함수의 편도 함수를 계산하는 방법을 보여 줍니다.

▲ 그림 3-6 로그 가능도 함수의 편도 함수 계산