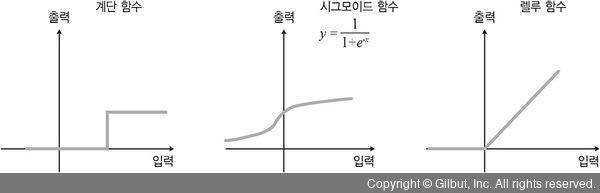

가중치와 함께 활성화 함수는 인공 신경망에서 가장 중요한 요소 중에 하나이다. 활성화 함수로 어떤 것을 선택하느냐에 따라 가중치의 최적화도 모두 영향을 받으며 모형의 성능에도 직결된다. 그림 8-12와 같이 다양한 활성화 함수를 통해 실험해보며 적절한 함수를 고르는 것이 중요한 과제이다.

▲ 그림 8-12 다양한 활성화 함수

이제 인공 신경망을 좀 더 확장해보자. 앞서 우리는 입력층-은닉층-결과층으로 구성된 단순한 구조의 인공 신경망을 대상으로 이해하였다. 이때 은닉층에 들어갈 노드의 수는 정해진 규칙이 없다. 주어진 변수 X의 수보다 적거나, 같거나, 많게 할 수도 있는데, 각 의미는 대체적으로 다음과 같다. 은닉층의 노드 수가 변수 X보다 적다면 기존 X의 차원(X에 해당하는 변수의 개수)을 축소하는 추상화의 과정이고, 변수 X보다 많다면 기존 X의 차원을 확장하는 추상화의 과정이다.

인공 신경망의 은닉층은 반드시 한 층일 필요는 없으며 여러 층으로 구성되기도 한다. 은닉층이 한 층인 경우에도 꽤나 계산이 복잡한데, 여러 층이면 그 계산은 더 복잡해질 것이다. 과연 몇 개의 은닉층과 은닉층마다 몇 개의 노드를 구성하는 것이 적절할까? 이에 대해 명확한 원칙이나 규칙은 없으며 지난한 분석과 시행착오를 통해 알아가야 한다. 이러한 점이 바로 인공 신경망의 난제이다. 최근에는 AutoML이라고 하여, 이런 시행착오를 자동화하는 알고리즘도 구현되어 사용되기 시작했다.