Wxh는 입력층에서 은닉층으로 전달되는 가중치이고, Whh는 t 시점의 은닉층에서 t+1 시점의 은닉층으로 전달되는 가중치입니다. 또한, Why는 은닉층에서 출력층으로 전달되는 가중치입니다. 가중치 Wxh, Whh, Why는 모든 시점에 동일하다는 것에 주의할 필요가 있습니다. 즉, 가중치를 공유하는데 그림 7-10과 같이 모든 가중치가 동일한 것을 확인할 수 있습니다.

이제 t 단계에서의 RNN 계산에 대해 알아보겠습니다.

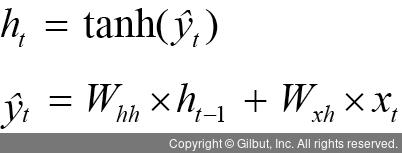

1. 은닉층 계산을 위해 xt와 ht-1이 필요합니다. 즉, (이전 은닉층×은닉층 - 은닉층 가중치 + 입력층 - 은닉층 가중치×(현재) 입력 값)으로 계산할 수 있으며, RNN에서 은닉층은 일반적으로 하이퍼볼릭 탄젠트 활성화 함수를 사용합니다. 이를 수식으로 나타내면 다음과 같습니다.

2. 출력층은 심층 신경망과 계산 방법이 동일합니다. 즉, (은닉층 - 출력층 가중치×현재 은닉층)에 소프트맥스 함수를 적용합니다. 이를 수식으로 나타내면 다음과 같습니다.