상태-가치 함수

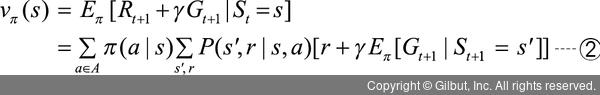

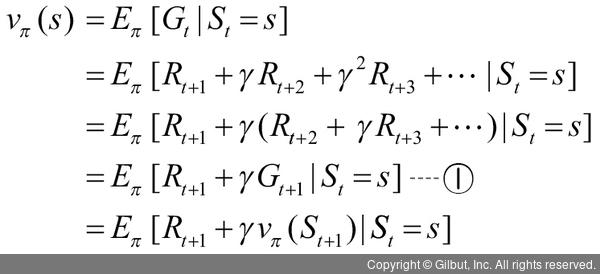

MDP의 상태-가치 함수를 벨만 방정식으로 표현하기 위해 앞의 수식을 다시 살펴보겠습니다.

① 수식에서 Rt+1, γGt+1과 기댓값을 분리해서 생각해 봅시다.

먼저 기댓값을 풀어서 이야기하면, 기댓값은 현재 상태에서 정책에 따라 행동했을 때 얻을 수 있는 각각의 행동(π(a|s))과 그 행동이 발생할 확률(p(s′,r|s,a))을 곱한 것입니다. 즉, 현재 기대되는 결과에 그 결과가 일어날 확률로 가중치가 곱해진 것과 같습니다.

Rt+1은 현재 행동을 선택했을 때 즉각적으로 얻어지는 보상이며, γGt+1은 더 미래에 일어날 보상에 할인율이 곱해진 것이라고 했습니다. γGt+1은 또다시 기댓값으로 풀어 쓴다면 ‘미래에 일어날 모든 일의 평균치’와 같은 의미로 사용할 수 있습니다. 따라서 이것을 정리하면 다음 수식으로 나타낼 수 있습니다.