■ 활성화 함수 ③ 렐루 함수

세 번째 활성화 함수는 렐루(ReLU) 함수입니다. 이 함수는 앞에서 살펴본 시그모이드 함수와 하이퍼볼릭탄젠트 함수와는 그 모습이 다릅니다.

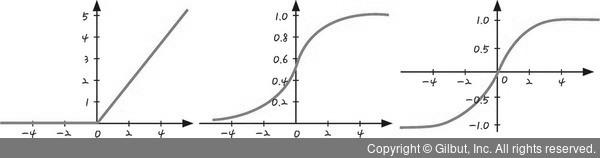

그림 5-12 | 렐루 함수, 시그모이드 함수, 하이퍼볼릭탄젠트 함수의 그래프

그림 5-12의 가장 왼쪽이 렐루 함수입니다. 이 함수의 모양을 살펴보면 입력값이 0보다 작은 숫자일 때는 0으로 바꾸어서 내보내는 것을 볼 수 있습니다. 그리고 입력값이 0보다 클 때는 입력받는 값이 출력되는 모습을 볼 수 있습니다. 5를 입력하면 그대로 5를 내보내는 것과 같이 말이죠.

이 함수의 이름이 ReLU(Rectified Linear Unit)인 이유도 바로 이것입니다. ‘고르게 한다’는 뜻의 Rectified와 ‘직선으로 이루어진’이라는 뜻의 Linear Unit이 결합된 것이죠. 시그모이드 함수, 하이퍼볼릭탄젠트 함수와는 한눈에 봐도 차이가 보입니다.

앞에서 살펴본 시그모이드 함수와 하이퍼볼릭탄젠트 함수는 인공 신경망으로 학습할 때 여러 이유에서 학습이 효과적으로 이루어지지 않는다는 단점이 있었습니다. 입력값이 아무리 커도 1보다 큰 수로는 내보내지 않기 때문입니다.